Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

Tags

- 아스키코드

- 불 자료형

- 파이썬

- codeup

- 문자열

- face recognition

- 2차원배열

- 선택실행구조

- 반복실행구조

- 코드업

- 입출력

- bitwise

- 2진수

- 진수

- 비트단위논리연산

- 8진수

- 불 연산

- 기초100제

- input()

- 딥러닝

- 출력

- 산술연산

- Docker

- 16진수

- 종합

- 논리연산

- OpenCV

- 기초 100제

- 10진수

- 비교연산

Archives

- Today

- Total

DeepFlowest

[모두를 위한 딥 러닝 시즌2] 01_Simple_Linear_Regression 본문

728x90

반응형

SMALL

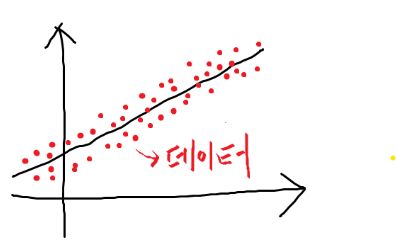

● Linear Regression

> 데이터에 잘 맞는 '직선'을 찾는 것이다.

즉, y=ax+b라는 직선이 있을 때 a와 b를 찾는 것이다.

● Hypothesis

> 어떤 가설이 더 좋을까? = 어떤 식이 더 좋을까?

==> 이것을 정하기 위해서 cost함수를 쓴다.

H(x) = Wx + b

(W : Weight, b : bias)

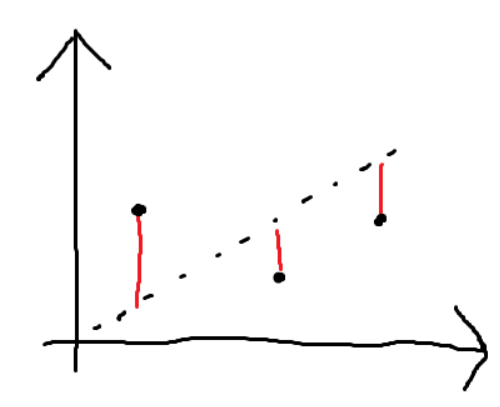

● Cost

H(x) - y

(예측 값- 실제 값)

=> '빨간색 선'들의 합이 작을 수록 good!

=> 이 차이를 cost, lost, error 라고 함.

==> 어떻게 이 cost 값을 최소화할까?

● Cost function

> error^2의 평균값

H(x) = Wx + b

=> Cost함수를 최소화하는 W와 b를 찾는 것

(학습의 목적이기도 함)

728x90

반응형

LIST

'딥러닝' 카테고리의 다른 글

| 앙상블 기법 ( 배깅, 부스팅 ) 개념 정리 (0) | 2020.09.25 |

|---|---|

| Gradient Descent_경사 하강법 (1) | 2020.07.28 |

| [모두를 위한 딥 러닝 시즌2] 04_Logistic_Regression_Binary_Classification (0) | 2020.07.16 |

| [모두를 위한 딥 러닝 시즌2] 03_Multi_variable_linear_regression (0) | 2020.07.16 |

| [모두를 위한 딥 러닝 시즌2] 02_How_to_minimize_cost (0) | 2020.07.16 |

Comments