| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

- 코드업

- 출력

- 2차원배열

- 논리연산

- 2진수

- 선택실행구조

- 기초 100제

- 비트단위논리연산

- 산술연산

- 문자열

- face recognition

- 기초100제

- Docker

- 입출력

- 불 연산

- 8진수

- 진수

- 종합

- 파이썬

- input()

- 불 자료형

- 비교연산

- bitwise

- OpenCV

- 10진수

- codeup

- 16진수

- 딥러닝

- 반복실행구조

- 아스키코드

- Today

- Total

DeepFlowest

[Video Inpainting] Deep Flow-Guided Video Inpainting 본문

https://arxiv.org/abs/1905.02884 논문을 읽고 정리한 내용 입니다.

0. Abstract

-

이 논문에서는 새로운 flow-guided video inpainting 접근을 제시한다.

-

RGB 픽셀을 직접 채우는 대신 video inpainting을 pixel propagation 문제로 간주함.

-

새로 설계된 Deep Flow Completion 네트워크를 사용하여 비디오 프레임 전반에 걸쳐 공간 및 시간적으로 일관된 optical flow field (spatially and temporally coherent optical flow field)를 합성함.

-

그리고 합성된 flow field를 사용하여 픽셀의 전파(propagation)를 안내하여 비디오에서 누락 된 영역을 채움.

-

이 방법은 DAVIS 및 YouTube-VOS 데이터 세트에서 질적 및 양적으로 평가되어 inpainting 품질 및 속도 측면에서 최첨단 성능을 달성함

1. Introduction

-

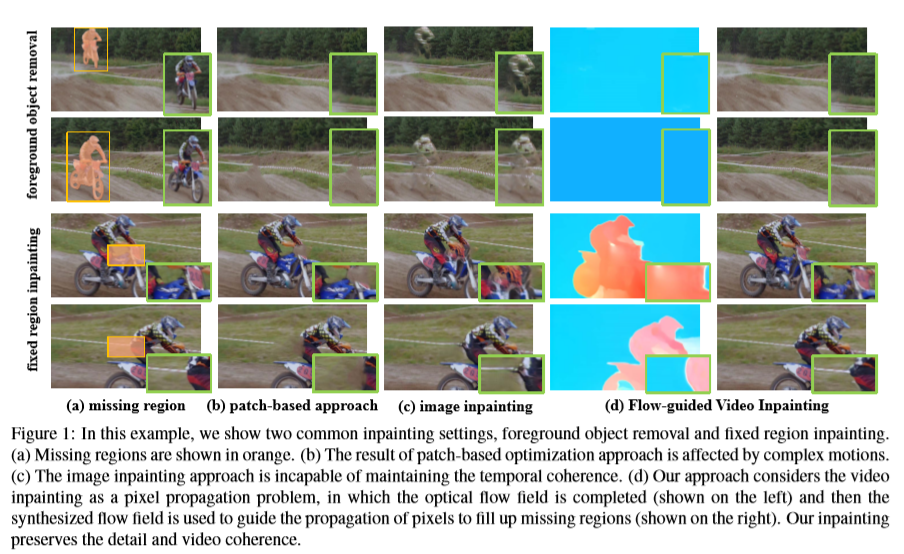

video inpainting의 목표는 주어진 비디오 시퀀스의 누락 된 영역을 공간 및 시간적으로 일관성있는 내용으로 채우는 것이다. [4, 12, 22, 24]. ( 원하지 않는 개체 제거 [9] 및 비디오 복원 [32] )

-

실제 고화질 비디오 시퀀스를 inpainting하는 것은 카메라 움직임과 물체의 복잡한 움직임으로 인해 여전히 어려움.

-

대부분의 기존 비디오 인 페인팅 알고리즘 [12, 21, 22, 27, 30]은 patch-based optimization 작업으로 문제를 공식화하여 기존의 이미지 inpainting pipeline을 따른다.

-

patch-based optimization 작업은 알려진 것의 공간 또는 공간-시간 패치(spatial-temporal patches)를 샘플링하여 누락 된 영역을 채운다.

-

이 patch-based optimization 접근 방식에는 두 가지 단점이 있음.

-

첫째, 일반적으로 누락 된 영역에서 부드럽고 균일 한 모션 필드를 가정하므로 복잡한 모션이있는 비디오를 처리 할 수 없음 (예 - 아래 그림의 (b)부분 )

-

둘째, 최적화 기반 방법의 계산 복잡성이 높기 때문에 이러한 방법은 실제 응용 프로그램에서 실행 불가능함. (예 - Huang et al. [12] 18 % 누락 된 영역이 포함 된 90 개의 프레임이있는 854 × 480 크기의 비디오를 칠하는 데 약 3 시간이 걸림.)

-

-

-

CNN (Convolutional Neural Network) [18]을 사용하여 image inpainting [15, 17, 23, 26, 35]에서는 발전이 많이 되었지만, video inpainting은 덜 발전됨.

-

딥 러닝 기반 image inpainting 접근 방식을 video 도메인으로 확장하는 데는 몇 가지 문제가 있다.

-

위 그림 1 (c)에서 볼 수 있듯이 각 프레임에 image inpainting 알고리즘을 개별적으로 적용하면 일시적인 artifacts(인위적인 결과) 발생

-

반면에 RGB 프레임의 양이 많기 때문에 전체 비디오 시퀀스를 한 번에 3D CNN에 공급하는 것도 시간적 일관성(temporal coherence)을 보장하기가 어려움.

-

한편, 전체 비디오 시퀀스를 직접 inpainting하려면 매우 큰 모델 용량이 필요하며, 이는 대용량 메모리 소비를 고려할 때 계산적으로 실용적이지 않다.

-

-

RGB 픽셀을 채우는 대신 이 논문에서는 video inpainting을 위한 **alternative flow-guided approach**을 제안한다.

-

이 논문에서의 접근 방식은 **누락 된 흐름을 완성하는 것**이 누락 된 영역의 픽셀을 직접 채우는 것보다 훨씬 쉬우며, 흐름을 사용하여 픽셀을 일시적으로 전파하면 시간적 일관성(temporal coherence)을 자연스럽게 보존한다는 것이다.

-

그림 1 (d)에서 볼 수 있듯이 RGB 픽셀에 비해 optical flow는 배경과 장면의 대부분의 개체가 일반적으로 추적 가능한 동작을 가지고 있기 때문에 훨씬 덜 복잡하고 완료하기 쉬움.

==> 프레임 전반에 걸쳐 일관된 flow field를 먼저 합성하여 video inpainting의 어려움을 완화하는 방법을 설계하도록 영감을 줌.

-

누락된 영역의 대부분의 픽셀은 visible regions에서 전파되고 뒤틀릴 수 있다.

-

마지막으로 픽셀 환각(pixel hallucination)을 사용하여 전체 비디오에서 볼 수 없는 작은 영역을 채울 수 있다.

-

비디오에서 optical flows을 채우기 위해 다음과 같은 기술적 참신함을 갖춘 새로운 **DFC-Net (Deep Flow Completion Network)**을 설계

(1) Coarse-to-fine refinement ( ~ 수정 )

-

제안 된 DFC-Net은 누락 된 영역에서 정확한 flow field을 복구하도록 설계되었다.

-

이는 세 개의 유사한 하위 네트워크 (DFC-S)를 쌓아서 대략적인 흐름 완성을 수행함으로써 가능

-

특히, 첫 번째 subnetwork는 연속 된 프레임의 배치를 입력으로 받아들이고 상대적으로 대략적인 스케일로 중간 프레임의 누락 된 flow를 추정함.

-

대략적으로 추정 된 flow fields의 batch는 추가 공간 해상도 및 정확도 개선을 위해 두 번째 subnetwork에 이어 세 번째 subnetwork 에 공급된다.

(2) Temporal coherence maintenance ( 시간적 일관성 유지 )

-

DFC-Net은 하위 네트워크가 매번 단일 프레임만 예측하더라도 자연스럽게 전역 시간 일관성(global temporal consistency)을 장려하도록 설계되었다.

-

이것은 더 풍부한 시간 정보를 제공하는 입력으로 연속 프레임 배치를 공급함으로써 달성된다.

-

또한 인접한 프레임 간의 매우 유사한 입력은 연속적인 결과를 생성하는 경향이 있다.

(3) Hard flow example mining

-

flow 경계 및 동적 영역(dynamic regions)의 도장 품질을 향상시키기 위해 hard flow example mining 전략을 쓴다.

2. Related Work

생략 - 논문 참고

3. Methodology

생략 - 논문 참고

4. Experiments

1) Inpainting Settings

-

이 논문에서는 2가지 inpainting settings을 고려한다.

-

첫 번째 settings

이전 작업 [12, 22]에서 살펴본 원하지 않는 foreground object를 제거하는 것이다. 이 settings에서는 foreground object의 영역을 윤곽을 그리는 마스크가 제공된다.

-

두 번째 settings

foreground 또는 background를 포함 할 수있는 비디오의 임의 영역을 채우려 한다. 이 설정은 watermark 제거 및 비디오 복원과 같은 일부 실제 응용 프로그램에 해당한다.

-

이러한 상황을 시뮬레이션하기 위해 [15, 35]에 따라 비디오 프레임 중앙의 정사각형 영역이 채워질 누락 영역으로 표시된다.

-

달리 명시되지 않는 한, 크기가 HxW 인 비디오 프레임의 경우 정사각형 누락 영역의 크기를 H/4×W/4로 고정한다.

-

non-foreground mask는 일반적으로 부정확 한 flow field로 이어지며, 이 설정을 더 어렵게 만든다.

-

2) Datasets

-

flow-guided video inpainting approach의 효과와 일반화 능력을 입증하기 위해 DAVIS [25]와 YouTubeVOS [34] 데이터 세트로 평가한다.

-

DAVIS 데이터 셋

-

150 개의 고품질 비디오 시퀀스를 포함

-

그 중 90개 비디오 : test data set (픽셀 단위 foreground object masks로 주석이 달린 모든 프레임)

-

그 중 60개 비디오 : train data set (라벨이 지정되지 않은)

-

DAVIS는 원래 video inpainting 알고리즘의 평가를 위해 제안되지 않았지만 정확한 object mask 주석 때문에 여기에 채택되었다.

-

-

YouTube-VOS 데이터 셋

-

4,453 개의 동영상으로 구성되어 있으며

-

train : 3,471 개

-

validation : 474 개

-

test : 508 개

-

YouTube-VOS는 dense object mask 주석을 제공하지 않기 때문에 두 번째 inpainting setting에서 모델의 성능을 평가하는 데만 사용한다.

-

3) Data Preparation and Evaluation Metric

-

FlowNet 2.0 [16]은 flow 추출에 사용 된다. 다음과 같이 데이터를 준비할 때 2가지 inpainting settings이 있다.

(1) Setting 1 : foreground object 제거

-

training set을 준비하기 위해서, 랜덤한 모양의 mask를 비디오의 각 프레임에 합성한다.

-

실제 object mask를 시뮬레이션 하기 위해 랜덤한 motion 도입

-

masked frames과 unmasked frames는 training 쌍을 생성함.

-

testing을 위해 제거 된 영역에 대한 근거가 없기 때문에 사용자 연구를 통해 evaluations을 수행함.

(2) Setting 2 : fixed region inpainting

-

각 training frames들은 프레임 중앙에 고정 된 사각형 영역으로 덮여 있다.

-

masked frames과 unmasked frames는 training 쌍을 생성함.

-

testing을 위해 사용자 연구 외에도 이 setting에서 [20, 33]에 따라 PSNR 및 SSIM을 쓴다.

-

PSNR은 이미지의 왜곡을 측정하고 SSIM은 두 이미지 간의 구조 유사성을 측정한다.

4.1. Main Results

-

이 논문에서의 DAVIS 및 YouTube-VOS 데이터 세트에 대한 접근 방법은 기존 방법과 다르다.

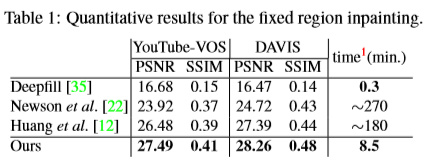

1) Quantitative Results

-

고정 된 누락 영역을 채우는 것을 목표로하는 두 번째 inpainting 작업에서 기존 방법과 양적으로 비교한다.

-

아래 Table 1에서 나온 것처럼, 두 데이터 세트에서 최고의 성능을 달성함.

-

또한, 각 프레임에 image inpainting 알고리즘 [35]을 직접 적용하면 결과가 나빠진 것을 볼 수 있다.

-

기존의 video inpainting 접근 방식 [12, 22]과 비교할 때 이 논문에서의 접근 방식은 복잡한 동작이있는 비디오를 더 잘 처리 할 수 있다.

-

한편, 이 논문에서의 접근 방식은 런타임 속도가 상당히 빠르므로 실제 응용 프로그램에 더 적합하다.

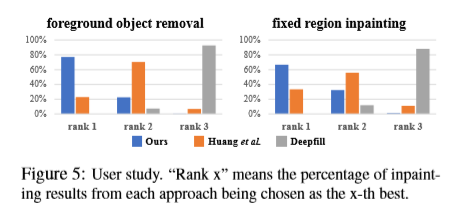

2) User study

-

원래 비디오 프레임에 대한 많은 합리적인 솔루션이 있기 때문에 Evaluation metrics는 완벽하지 않다.

-

따라서 이 논문에서는 접근 방식과 기존 작업의 성능을 정량화하기 위해 사용자 연구(user study)를 수행한다 [12, 35].

-

DAVIS 데이터 셋에서 학습 된 모델을 사용하고, 각 참가자에 대해 DAVIS testing set에서 15 개의 비디오를 무작위로 선택한다.

-

그런 다음 두 가지 다른 setting에서 세 가지 접근 방식 (Ours, Deepfil [35], Huang et al. [12])으로 비디오를 inpaint한다.

-

details를 더 잘 display 하기 위해 비디오는 낮은 프레임 속도 (5FPS)로 재생한다.

-

각 비디오 샘플에 대해 참가자는 비디오가 재생 된 후 세 가지 inpainting 결과의 순위를 지정해야한다.

-

User study에 30 명 참가했고, 결과는 정량적 결과(quantitative result)와 일치하는 아래 그림 5에 나와있다.

-

이 논문(Ours)에서의 접근 방식은 다른 두 기준선보다 현저히 우수한 성능을 보이는 반면 image inpainting 방법은 출력에서 시간적 일관성(temporal consistency)을 유지하도록 설계되지 않았기 때문에 최악의 성능을 발휘한다.

-

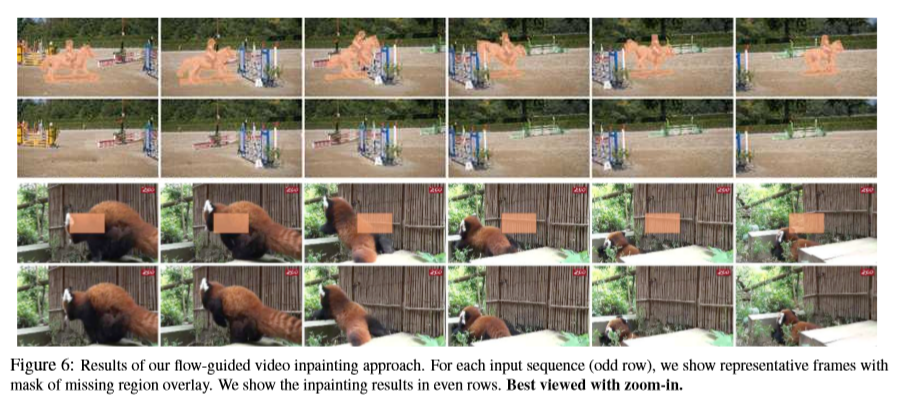

아래 그림 6은 inpainting 결과의 몇 가지 예를 보여준다.

3) Qualitative Comparison

-

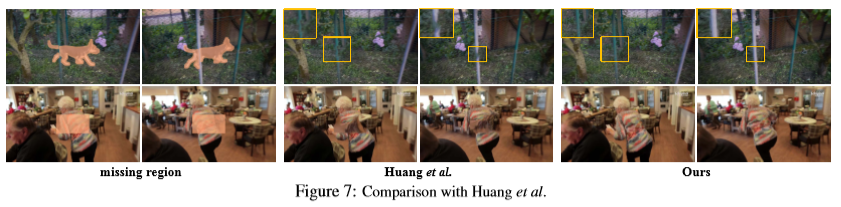

아래 그림 7에서 두 가지 다른 settings에서 Ours와 Huang et al.의 방법을 비교

-

이 논문에서의 DFC-Net가 flow를 더 잘 완성했다.

-

완성 된 flow 덕분에 모델은 정확한 픽셀 값으로 영역을 쉽게 채울 수 있다.

4.2. Ablation Study

-

이 논문의 flow guided video inpainting 접근 방식에서 각 구성 요소의 효과를 분석하기 위해 일련의 제거 연구(ablation study)를 수행한다.

-

training set로 YouTube-VOS 데이터 셋 사용

-

더 나은 정량적 비교(quantitative comparison) 를 위해 모든 performances는 두 번째 inpainting setting에서 YouTube-VOS의 validation set 에서 수행한다. (이 setting에서 제거 된 영역에 대한 근거가 있기 때문)

1) Comparison with Image Inpainting Approach

-

이 논문의 flow guided video inpainting 접근 방식은 합성 된 flow fields를 guidance로 사용하여 video inpainting 작업을 상당히 쉽게한다.

(비디오 완성 문제를 픽셀 전파 작업(pixel propagation task)으로 변환하여서)

-

이 패러다임의 효과를 입증하기 위해 각 프레임에 대한 direct image inpainting network와 비교한다.

-

공정한 비교를 위해 Deepfill architecture 채택 (입력으로 여러 색상 프레임을 사용해서 'Deepfill+Multi-Frame'이라고 부름.)

-

그런 다음, 'Deepfil + Multi-Pass' 아키텍처는 DFCNet과 같은 3 개의 'Deepfil + Multi-Frame'을 쌓는다.(stack)

-

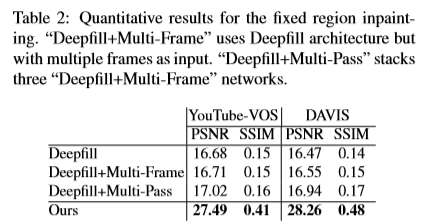

아래 Table 2는 DAVIS와 YouTube-VOS 모두에서 inpainting 결과를 보여준다.

-

multi-frame input과 stacking architecture는 Deepfil에 비해 약간의 향상된 것을 볼 수 있다.

-

‘Deepfill+Multi-Frame’ 과 이 논문 방법 사이의 상당한 차이는 고품질의 완성 된 flow field를 guidance로 사용하는 것이 video inpainting 작업을 쉽게 할 수 있다는 것을 보여준다.

2) Effectiveness of Hard Flow Example Mining

-

3.2에서 나왔듯이, 대부분의 optical flow 영역은 매끄럽고 모델이 저하 될 수 있다.

-

따라서, flow inpainting에서 label bias의 영향을 완화하기 위해, hard flow example mining mechanism이 제안된다.

-

마찬가지로, 이 실험에서는 첫 번째 DFC-S를 채택하여 hard flow example mining의 효과를 조사한다.

-

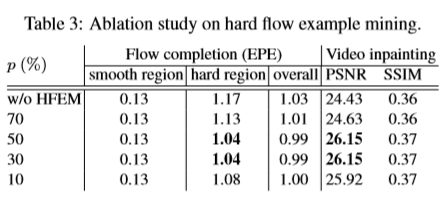

아래 Table 3은 다른 mining settings에서 flow 완료 정확도와 해당 inpainting 성능을 나열한다.

-

파라미터 p는 hard 하나로 label되는 샘플의 비율을 나타낸다.

-

여기서, inpaint된 flow를 평가하기 위해 end-point-error (EPE) 메트릭을 사용한다.

-

명확한 데모를 위해 모든 flow 샘플은 분산(variance)에 따라 매끄럽고 비 매끄럽지 않은 세트로 나뉜다.

-

전반적으로, hard flow example mining mechanism은 모든 settings에서 성능을 향상시킨다.

-

p가 더 작으면, 샘플이 더 harder하다는 것을 의미하며 training 중 난이도가 증가한다.

-

p가 더 크면, 모델은 기준선(baseline)에 비해 크게 개선되지 않는다.

-

p의 최선의 선택 범위는 30 %에서 50 %이고, 이 실험에서 p를 50 %로 고정한다.

3) Effectiveness of Stacked Architecture

-

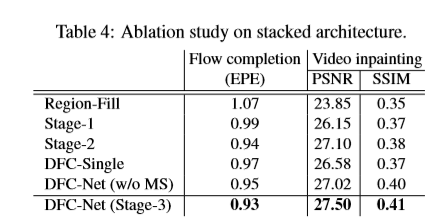

위 Table 4는 flows 및 해당 inpainting frames을 포함하여 DFC-Net의 단계별 개선 결과를 보여준다.

-

스택 형(stacked) DFC-Net의 효과를 추가로 입증하기 위해 Table 4에는 다음과 같이 구성된 두 가지 다른 기준선(baselines)도 포함되어 있다.

1) DFC-Single

-

DFC-S와 유사한 단일 stage flow 완료 네트워크

-

공정한 비교를 위해 DFC-Single은 더 깊은 뼈대인 ResNet-101을 채택함.

2) DFC-Net (w/o MS)

-

DFC-Net (w/o MS)의 아키텍쳐는 DFC-Net과 동일함.

-

그러나, baseline model의 각 단계에서 input의 scale은 변하지 않으며, 데이터는 처음부터 끝까지 전체 resolution이다.

-

-

Table 4를 보면, endpoint-error가 coarse-to-fine한 수정()에 의해 점차 감소한다는 것을 알 수 있다.

-

DFC-Single의 결과는 두 번째 단계에 비해 다소 열등하여, 이 작업에서 stacked architecture를 사용하는 것이 효과적임을 보여준다.

-

각 단계에서 multi-scale 입력 사용의 효율성을 추가로 나타내기 위해 DFC-Net과 DFC-Net (w/o MS)을 비교한다.

-

성능 차이는 초기 단계에서 대규모 입력을 사용하면, 일반적으로 훈련이 불안정해 지므로 각 단계에서 multiscale 입력을 사용하는 전략이 모델의 결과를 개선한다는 것을 입증한다.

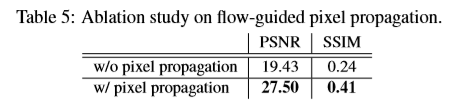

4) Effectiveness of Flow-Guided Pixel Propagation

-

완성된 flow를 얻은 후, 모든 알려진 픽셀은 먼저 유효한 estimated flow을 기반으로 누락 된 영역을 채우기 위해 양방향으로 전파(propagate)된다.

-

이 단계는 고품질 결과를 생성하고 다음 단계에서 처리해야하는 누락 영역의 크기를 줄인다.

-

아래 Table 5에서 볼 수 있듯이, image inpainting 및 flow warping을 직접 사용하여 보이지 않는 영역을 inpainting하는 기본 접근 방식(baseline approach)과 비교하여, 이 중간 단계는 작업을 크게 줄이고 전반적인 성능을 향상시킨다.

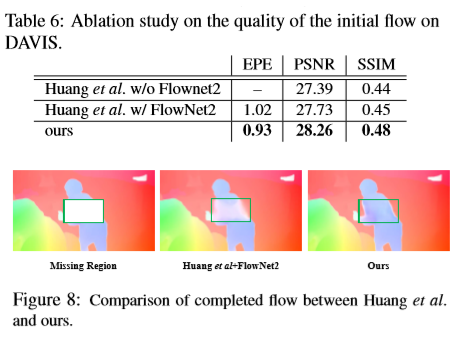

5) Ablation Study on Initial Flow

-

flow estimation algorithm은 중요하지만 누락 된 영역 외부의 flow 품질에만 영향을 미치기 때문에 중요하지는 않다.

-

대조적으로, 누락 된 영역 내부의 완료된 flow의 품질이 더 중요하다.

-

공정한 비교를 위해 [12]의 초기 flow를 FlowNet2에서 추정(estimated)한 flow로 대체한다.

-

Table 6 과 Fig. 8은 이 방법의 효과를 보여준다.

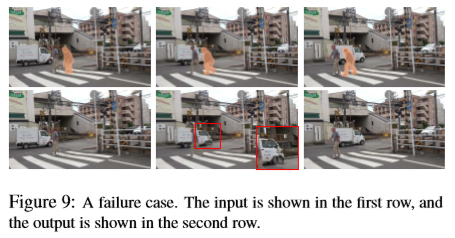

6) Failure Case

-

실패 사례가 Fig. 9. 에 나와 있는데, 이 경우 이 논문에서의 방법은 주로 완료된 flow가 자동차 가장자리에서 부정확하기 때문에 실패했다.

-

propagation process는 이를 수정할 수 없다.

-

앞으로는, 학습 기반 propagation 방법을 사용하여 추정 된 flow의 부정확성 영향을 완화 할 예정이다.

-

다른 더 최신의 flow 추정 방법[13, 14, 31]도 조사 될 것이다.

5. Conclusion

-

이 논문에서는 새로운 deep flow-guided video inpainting 접근법을 제안하여 고품질 flow 완성이 복잡한 장면에서 video inpainting을 크게 촉진 할 수 있음을 보여준다.

-

Deep Flow Completion 네트워크는 누락 된 영역의 임의의 형태, 복잡한 동작에 대처하고 시간적 일관성을 유지하도록 설계되었다.

-

이전 방법과 비교하면, 이 논문에서의 접근 방식은 런타임 속도가 상당히 빠르지만 누락된 영역과 비디오 콘텐츠의 움직임에 대한 가정이 필요하지 않다.

-

최첨단 성능으로 효과적인 DAVIS [25] 및 YouTube-VOS [34] 데이터 세트에 대한 접근 방식을 보여준다.

[ 요약 정리 ]

-

새로운 deep flow-guided video inpainting 접근법 제시

-

RGB 픽셀을 직접 채우는 대신 video inpainting을 pixel propagation문제로 간주함.

-

방식 :

Deep Flow Completion 네트워크를 사용하여 optical flow field를 합성

==> 합성된 flow field를 사용하여 픽셀의 propagation를 안내하여 비디오에서 누락 된 영역을 채움

※ DFC-Net (Deep Flow Completion Network) 설계 :

누락 된 영역의 임의의 형태와 복잡한 동작에 대처하고 시간적 일관성을 유지하도록 설계됨

(1) Coarse-to-fine refinement

(2) Temporal coherence maintenance ( 시간적 일관성 유지 )

(3) Hard flow example mining

4. 이 논문에서는 2가지 inpainting settings을 고려함.

1) 첫 번째 settings : 원하지 않는 foreground object를 제거

2) 두 번째 settings : foreground 또는 background를 포함 할 수있는 비디오의 임의 영역 채우기

'논문 정리 및 리뷰' 카테고리의 다른 글

| [Video Inpainting] DVI: Depth Guided Video Inpainting for Autonomous Driving (1) | 2020.10.12 |

|---|---|

| [Video Inpainting] Deep Video Inpainting (0) | 2020.10.05 |